Robert9

Themenersteller

Ein Objektiv x1 soll an der Naheinstellunfsgrenze einen Abbildungsmaßstab von 1:1 haben. Bei 36x24 mm dürfte mein Objekt dann genauso groß sein.

Mein Objekt x2 ist nun aber 360mm hoch. Dann müsste ich mit dem Objektiv weiter weg gehen. Mit Strahlensatz und Winkel/Brennweite müsste sich jetzt ausrechnen lassen wie weit ich weggehen muss. Dazu gibt es hier einen Rechner:

https://www.vision-doctor.com/optik-berechnungen/arbeitsabstand.html

Dieser Rechner berücksichtigt meinen Abbildungsmaßstab nicht, warum nicht?

Wenn A und B jeweils x mm Brennweite haben und einmal 1:1 und einmal 1:2 als Abbildungsmaßstab haben, sollte das Bild bei gleichem Objektabstand ein anderes sein, oder?

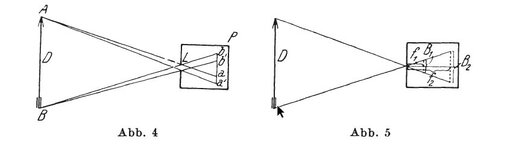

Angenommen mein Objektiv hätte keine optische Verzerrung, wo ist der Arbeitsabstand bei dem ich keine perspektivische Verzerrung habe? Dies dürfte auch abhängig sein von der sichtbaren Tiefe meines Objektes (Hand an ausgestrecktem Arm nach vorne z.B.)

Gibt es eine Formel zur Minimierung dieser perspektivischen Verzerrung in Abhängigkeit von Brennweite, Arbeitsabstand, Objektmaße, Abbildungsmaßstab?

Wenn ich fotografiere, mach ich das halt, so wie es sich für mich für richtig anfühlt.

Könnte man das aber auch berechnen?

Objekt x3 in Hohlkehle hat 360x120 mm inklusive ein bisschen Platz oben und unten. Das Objekt hat eine sichtbare Tiefe von bis zu 170mm.

Welche Brennweite mit welchem Abbildungsmaßstab nimmt mir bei welchem Arbeitsabstand das Objekt mit maximaler Füllung der Sensorfläche ohne perspektivische Verzerrung* auf?

* Ein bisschen Verzerrung ist vielleicht für das menschliche Sehen nicht verkehrt je nach Objektgröße bzw. Tiefe?

Mich interessiert das rein der Neugierde wegen bzw. vielleicht auch für die Objektivauswahl.

Z.B. habe ich noch keine Ahnung, ob ich das 14er Laowa lieber als EF mit 1:1 oder FE mit 1:14 haben will. Leider sind beide in meiner Stadt nicht vorrätig und bei einem der großen Anbieter hieß es direkt: Bestellen ja, aber ausprobieren nein.

Mein Objekt x2 ist nun aber 360mm hoch. Dann müsste ich mit dem Objektiv weiter weg gehen. Mit Strahlensatz und Winkel/Brennweite müsste sich jetzt ausrechnen lassen wie weit ich weggehen muss. Dazu gibt es hier einen Rechner:

https://www.vision-doctor.com/optik-berechnungen/arbeitsabstand.html

Dieser Rechner berücksichtigt meinen Abbildungsmaßstab nicht, warum nicht?

Wenn A und B jeweils x mm Brennweite haben und einmal 1:1 und einmal 1:2 als Abbildungsmaßstab haben, sollte das Bild bei gleichem Objektabstand ein anderes sein, oder?

Angenommen mein Objektiv hätte keine optische Verzerrung, wo ist der Arbeitsabstand bei dem ich keine perspektivische Verzerrung habe? Dies dürfte auch abhängig sein von der sichtbaren Tiefe meines Objektes (Hand an ausgestrecktem Arm nach vorne z.B.)

Gibt es eine Formel zur Minimierung dieser perspektivischen Verzerrung in Abhängigkeit von Brennweite, Arbeitsabstand, Objektmaße, Abbildungsmaßstab?

Wenn ich fotografiere, mach ich das halt, so wie es sich für mich für richtig anfühlt.

Könnte man das aber auch berechnen?

Objekt x3 in Hohlkehle hat 360x120 mm inklusive ein bisschen Platz oben und unten. Das Objekt hat eine sichtbare Tiefe von bis zu 170mm.

Welche Brennweite mit welchem Abbildungsmaßstab nimmt mir bei welchem Arbeitsabstand das Objekt mit maximaler Füllung der Sensorfläche ohne perspektivische Verzerrung* auf?

* Ein bisschen Verzerrung ist vielleicht für das menschliche Sehen nicht verkehrt je nach Objektgröße bzw. Tiefe?

Mich interessiert das rein der Neugierde wegen bzw. vielleicht auch für die Objektivauswahl.

Z.B. habe ich noch keine Ahnung, ob ich das 14er Laowa lieber als EF mit 1:1 oder FE mit 1:14 haben will. Leider sind beide in meiner Stadt nicht vorrätig und bei einem der großen Anbieter hieß es direkt: Bestellen ja, aber ausprobieren nein.

Zuletzt bearbeitet: